Este texto fue publicado en Nexos. Por considerarlo de interés público lo reproducimos aquí.

La semana pasada se presentaron los resultados del nuevo ranking para América Latina 2016, producido por el suplemento Times Higher Education, que se suma a la larga lista de rankings universitarios que existen en la actualidad. Los primeros rankings mundiales aparecieron hace más de una década, en 2003: el Academic Ranking World University (ARWU) y en 2004 el que nos ocupa ahora, junto con el QS World University Ranking. A estos rankings se han agregado otros de alcance internacional como el del periódico US News conocido como el World Review Best Global Universities Ranking; el Ranking Leiden o el del Center for World University Ranking (CWUR) y también otros producidos nacionalmente.

La semana pasada se presentaron los resultados del nuevo ranking para América Latina 2016, producido por el suplemento Times Higher Education, que se suma a la larga lista de rankings universitarios que existen en la actualidad. Los primeros rankings mundiales aparecieron hace más de una década, en 2003: el Academic Ranking World University (ARWU) y en 2004 el que nos ocupa ahora, junto con el QS World University Ranking. A estos rankings se han agregado otros de alcance internacional como el del periódico US News conocido como el World Review Best Global Universities Ranking; el Ranking Leiden o el del Center for World University Ranking (CWUR) y también otros producidos nacionalmente.

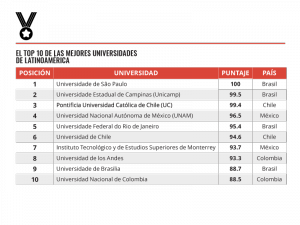

Mientras América Latina representa cerca del 12% de los alumnos inscritos en la educación superior en el mundo, la presencia de la región en los rankings mundiales es, por decir lo menos, precaria (apenas entre un 2% y un 4%). En la región son apenas unas cuantas las instituciones que aparecen en los rankings mundiales; la Universidad de São Paulo (USP) de Brasil resulta la mejor posicionada en la gran mayoría de todos. De hecho, la producción de artículos científicos de la USP es tan impresionante que a nivel internacional se coloca por encima de universidades de alto prestigio como la Universidad de Montreal de Canadá o la Universidad de Rutgers en EEUU. El resto de las universidades de la región aparecen intermitentemente en los rankings y son unas cinco las más constantes, entre las que destacan: la Universidad Nacional Autónoma de México (UNAM), la Pontificia Universidad Católica de Chile, la Universidad de Buenos Aires (UBA), el Instituto Tecnológico y de Estudios Superior de Monterrey (ITESM) y la Universidad Estatal de Campinas.

El ranking que se presentó la semana pasada en Bogotá recordó muchos de los problemas y cuestionamientos que los especialistas en educación superior han realizado a los rankings universitarios desde su aparición. En este caso, hay ausencias difíciles de comprender, aunque ello se debe a que no completaron el cuestionario correspondiente. Por ejemplo, no aparecen en este ranking instituciones muy importantes de México como la Universidad Autónoma Metropolitana (UAM) o el Instituto Politécnico Nacional (IPN); no se enlistó ninguna universidad de Argentina (incluyendo la UBA) o tampoco aparece la prestigiosa Universidad Nacional de Colombia.

Dado que los rankings usan diferentes metodologías y ponderaciones, por ejemplo, algunos recaban información de bases de datos de publicaciones y citas académicas, otros usan información de los sitios de internet de las universidades, otros piden llenar formularios y otros miden la “reputación” (a partir de encuestas a quienes ellos consideran líderes académicos o profesionales), la gama de lo que cada ranking mide y compara es enorme. A menos que se sea un experto en este tema, para un público general resulta difícil seguir los resultados que cada ranking publica anualmente.

Sin embargo, el tema de qué mide cada ranking no es el único problema de estos instrumentos. Por ejemplo, el ranking regional del Times Higher Education que recientemente se dio a conocer informa que tuvo que hacer una “recalibración” para los países latinoamericanos dado su contexto, con lo cual se le dio más peso a la enseñanza y a la investigación que al impacto de sus publicaciones (es decir, de sus citas académicas). Esta situación resultó en que, si bien, la UNAM aparece mejor posicionada que el ITESM a nivel mundial, en el regional el ITESM apareció un lugar arriba de la UNAM. Este fenómeno se reproduce también en la tabla QS con respecto a sus resultados mundiales y los de América Latina.

Sin embargo, el tema de qué mide cada ranking no es el único problema de estos instrumentos. Por ejemplo, el ranking regional del Times Higher Education que recientemente se dio a conocer informa que tuvo que hacer una “recalibración” para los países latinoamericanos dado su contexto, con lo cual se le dio más peso a la enseñanza y a la investigación que al impacto de sus publicaciones (es decir, de sus citas académicas). Esta situación resultó en que, si bien, la UNAM aparece mejor posicionada que el ITESM a nivel mundial, en el regional el ITESM apareció un lugar arriba de la UNAM. Este fenómeno se reproduce también en la tabla QS con respecto a sus resultados mundiales y los de América Latina.

Pero si los problemas técnicos de los rankings no fueran pocos, los cuestionamientos a su uso son amplios. Un tema central es qué modelo de universidad “premian” dichos rankings y cuál “penalizan”. El modelo exitoso en los rankings es el de la llamada universidad de “clase mundial”: universidades de mucho prestigio de países de lengua inglesa, con financiamiento y producción científica difícilmente comparables a otras instituciones en el mundo, con alta producción en revistas con impacto de sus citas académicas, que cuenta a galardonados con el premio Nobel, entre otros indicadores. Además consideran: el número de estudiantes inscritos, personal y profesores trabajando que son de origen internacional; los grados académicos del personal académico; los promedios maestro-alumno por salón de clase (dependiendo el ranking). Si a esto se agrega la selección de a quiénes se les pregunta y a quiénes no por la reputación de las universidades y sus egresados pues es entendible que la gran mayoría de universidades en el mundo, cuya función principal es la docencia y no la investigación, quedan excluidas.

Otro asunto es que estos rankings universitarios comienzan a ser importantes en la toma de decisiones –por ejemplo en la asignación de becas estudiantiles1– o en el desarrollo de políticas que privilegian un modelo único de hacer ciencia y difundirla, por lo que la riqueza de la diversidad de las instituciones de educación superior que atienden otros problemas como el acceso o equidad es relegada. También se debe discutir la falta de transparencia y rendición de cuentas por parte de quienes elaboran estos rankings, lo cual incluye presuntos actos de corrupción (caso QS) o cuestionamientos sobre su ética profesional. En su gran mayoría estos rankings son elaborados por empresas particulares (muchas de ellas vinculadas a periódicos o revistas). En América Latina, sólo en el caso de Colombia existe un ranking gubernamental, aunque su aparición tampoco fue bien vista en dicho país (Modelo de Indicadores del Desempeño de la Educación, MIDE). La mayoría de las empresas que elaboran estos rankings venden servicios de consultoría para mejorar la posición de las universidades en estas tablas, a lo que cabe la pregunta: ¿Dónde queda la transparencia en el avance de universidades que compraron un “paquete” para mejorar su posición en los rankings y al siguiente año en efecto mejoraron no un lugar sino en ocasiones hasta 20 o 50 lugares? O en la medida en que las universidades participan en el llenado de información de los propios rankings, los sistemas de estas empresas se vuelven más complejos y posteriormente pueden “vender” esa misma información para que una universidad se compare con otras de perfil similar; ante lo que cabe el cuestionamiento: ¿El uso de esa información de los participantes se vuelve un tema similar al que se presenta con plataformas privadas de información o programas/navegadores de internet?

Por último, los rankings miden el impacto y la producción del conocimiento (principalmente a partir de la bibliometría), de perfiles de académicos de ciertas disciplinas y en general de modelos alejados del común de nuestras universidades (al menos en América Latina). Si bien, las voces que alertan sobre los problemas de los rankings crecen, su influencia también aumenta junto con la ansiedad y malestar que producen en las comunidades universitarias. Un primer paso para ubicar a los rankings en sus justa dimensión es hablar de sus problemas a públicos más amplios. Otro paso es dejar claro que los rankings no pueden ser la nueva y única medida para valorar el papel de las universidades (tanto públicas como privadas). Mientras estos rankings no consideren temas como la inclusión social, la reducción de la inequidad, el acceso de primeras generaciones al nivel terciario, difícilmente contribuirán a realizar una valoración más justa de las universidades en las sociedades latinoamericanas.

Por último, los rankings miden el impacto y la producción del conocimiento (principalmente a partir de la bibliometría), de perfiles de académicos de ciertas disciplinas y en general de modelos alejados del común de nuestras universidades (al menos en América Latina). Si bien, las voces que alertan sobre los problemas de los rankings crecen, su influencia también aumenta junto con la ansiedad y malestar que producen en las comunidades universitarias. Un primer paso para ubicar a los rankings en sus justa dimensión es hablar de sus problemas a públicos más amplios. Otro paso es dejar claro que los rankings no pueden ser la nueva y única medida para valorar el papel de las universidades (tanto públicas como privadas). Mientras estos rankings no consideren temas como la inclusión social, la reducción de la inequidad, el acceso de primeras generaciones al nivel terciario, difícilmente contribuirán a realizar una valoración más justa de las universidades en las sociedades latinoamericanas.

Investigadora del DIE-Cinvestav